La robótica es un campo en constante evolución, pero aún enfrenta límites. Los robots actuales suelen carecer de adaptabilidad, lo que limita su ámbito de aplicación. Para superar estos límites, los científicos están explorando un nuevo camino: la integración de grandes modelos de lenguaje (LLM) en robótica.

Ofrecer a los robots mayor flexibilidad en todos los escenarios

Los investigadores están explorando nuevas vías para superar los límites de la robótica. Por ejemplo, Ishika Singh, estudiante de doctorado en informática de la Universidad del Sur de California, planea crear un robot capaz actuar de forma totalmente autónoma. Esto, explotando grandes modelos de lenguaje como ChatGPT.

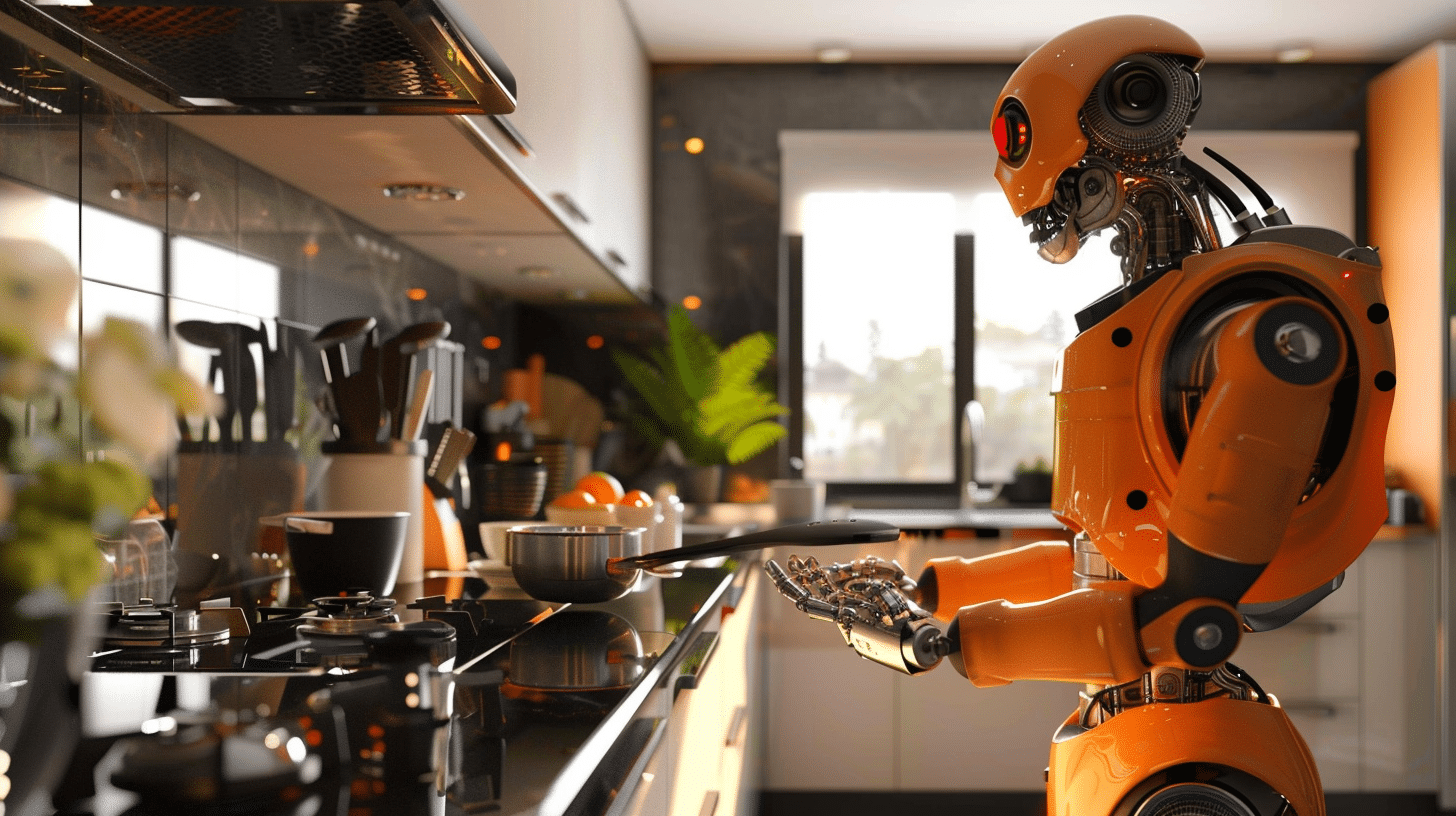

Por ejemplo, en la restauración, los robots ya son capaces de cocinar comidas o realizar tareas específicas gracias a una programación fija. Continuamente repiten los mismos pasos. La ambición de este investigador es crear un robot capaz de preparar la cena de la A a la Z de forma independiente. El robot debería poder considerar las preferencias dietéticas de cada uno y adaptarse a solicitudes específicas.

Según Jesse Thomason, profesor de informática de la Universidad del Sur de California y asesor de tesis de Singh, un robot tan versátil es un objetivo ambicioso. Revolucionaría nuestras vidas y simplificaría nuestra vida diaria.

Combinando LLM y tecnología robótica

Otros expertos también están considerando combinar modelos de lenguajes grandes (LLM) y robots. De hecho, los LLM tienen conocimiento impresionante, pero no pueden interactuar físicamente con el mundo real. Por el contrario, los robots tienen “manos y ojos” que les permiten actuar sobre su entornopero carecen de la inteligencia de los LLM.

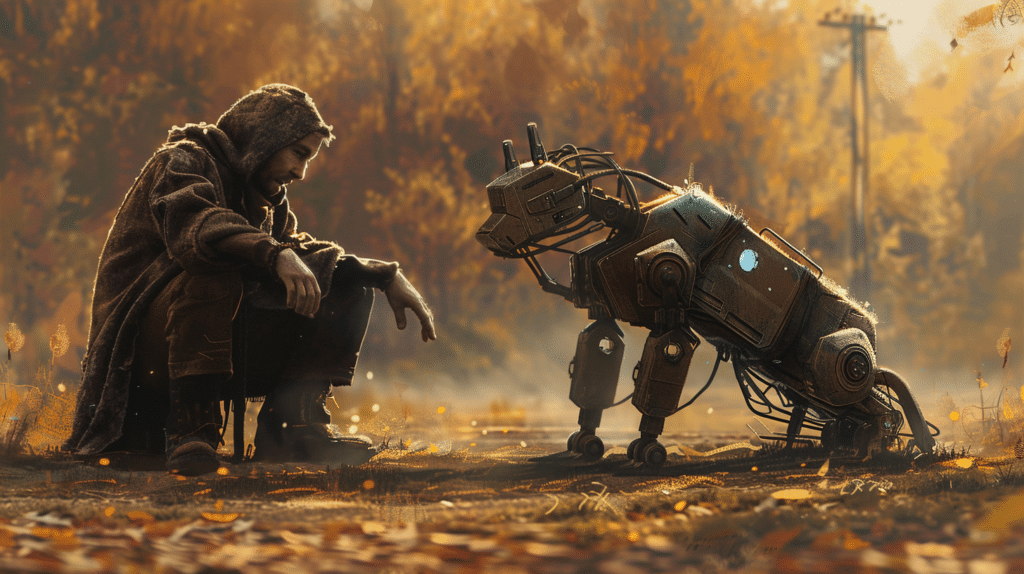

Algunos prototipos ya ilustran esta unión de alta tecnología. Por ejemplo, la empresa Levantas equipó a los perros robot Boston Dynamics con voz ChatGPT. Estos pueden responder preguntas y seguir instrucciones. Actualmente utilizados en industrias, podrían utilizarse en el futuro en hogares.

El proyecto SayCan de Google

En Google, un equipo de investigadores, entre ellos Karol Hausman y Brian Ichter, está experimentando con un enfoque innovador para transformar las capacidades de un LLM en acciones concretas de un robot. Su proyecto SayCan se basa en el modelo PaLM al que someten una lista de posibles acciones. El robot debe seleccione la acción más adecuada para responder a una solicitud. Entonces, cuando un humano realiza una solicitud, PaLM analiza la solicitud y extrae de su repertorio los comportamientos más adecuados para responder a ella.

Por ejemplo, un usuario acaba de hacer deporte y le pide al robot que le traiga una bebida y un snack para recuperarse adecuadamente. El modelo inicialmente juzga que un la botella de agua satisface mejor la necesidad que una manzana. La botella traída, entonces considera que ahora debe buscar la manzana.

El objetivo final de los investigadores es lograr una mayor nivel de comprensión. Por ejemplo, cuando le pidan ayuda después de una mala noche, debería saber traer café.

Desafíos a superar a pesar de los avances

El proyecto SayCan de Google es un verdadero progreso. Sin embargo, expertos como el psicólogo Gary Marcus plantean reservas sobre la confiabilidad y la comprensión aún limitada de los LLM en comparación con los programas tradicionales.

Según ellos, el despliegue a gran escala de estos modelos en aplicaciones públicas en general, incluidos los robots podría presentar riesgos. Esto se debe a posibles malentendidos de las expectativas de los usuarios o solicitudes mal interpretadas. Para afrontar estos desafíos, enfoques híbridos Se debe considerar combinar capacidades de simulación LLM y planificación tradicional.

Nuestro blog está impulsado por lectores. Cuando compra a través de enlaces en nuestro sitio, podemos ganar una comisión de afiliado.