Meta acaba de presentar V-JEPA, su nuevo modelo de IA que revoluciona el entrenamiento de la inteligencia artificial. Su particularidad ? Es capaz de interpretar la información contenida en un vídeo y aprender como lo hacen los humanos.

Un modelo de IA no generativo, centrado en conceptos abstractos.

V-JEPA, Fue desarrollado por Yann LeCun, científico jefe del laboratorio de IA de Meta. A diferencia de los LLM habituales, este no es un modelo de IA generativa. V-JEPA aprende de manera diferente a otras IA.

En lugar de centrarse en la precisión píxel por píxel para generar nuevas imágenes realistas, utiliza conceptos abstractos para aprender. Por tanto, intenta comprender lo que sucede en el vídeo: la presencia de objetos específicos (árboles, personas, animales) y las relaciones entre ellos.

Esta forma de aprender se parece a la forma de aprender. niños. Observan lo que sucede a su alrededor y tratar de darle sentido a lo que ven.

Una forma más natural de aprender

Durante la capacitación de V-JEPA, los investigadores ocultar varias partes grandes de los videos. Luego, el modelo debe adivinar lo que falta. Al hacerlo, aprende a hacer inferencias lógicas sobre el curso de los acontecimientos.

Esta forma de aprender también es similar a la de los humanos. Es un poco como un niño que ve a una persona ir a recuperar una pelota. Ella desaparece de su campo de visión. Luego ella regresa. El niño no No puedo ver cada paso de la acción.. Sin embargo, utilizando sus habilidades de observación y razonamiento, comprende la lógica de la secuencia de eventos.

Mejora de la eficiencia del entrenamiento

Este enfoque innovador adoptado por V-JEPA es muy prometedor. Según los investigadores detrás del proyecto, permite acelerar considerablemente el entrenamiento de la inteligencia artificial, la haciéndolo de 1,5 a 6 veces más efectivo. Además, V-JEPA puede aprender de datos de vídeo sin etiquetar. No es necesario especificar de antemano qué objetos o acciones están presentes en la pantalla.

Además, este Meta modelo logra distinguir interacciones sutiles entre diferentes objetos. Por ejemplo, él puede identificar acciones muy similares como levantar, dejar o pretender dejar un bolígrafo. Sin embargo, por el momento, V-JEPA sólo funciona en secuencias cortas, de unos diez segundos. Pero, es seguro que su rendimiento mejorará con el tiempo.

Hacia una IA más inteligente y autónoma

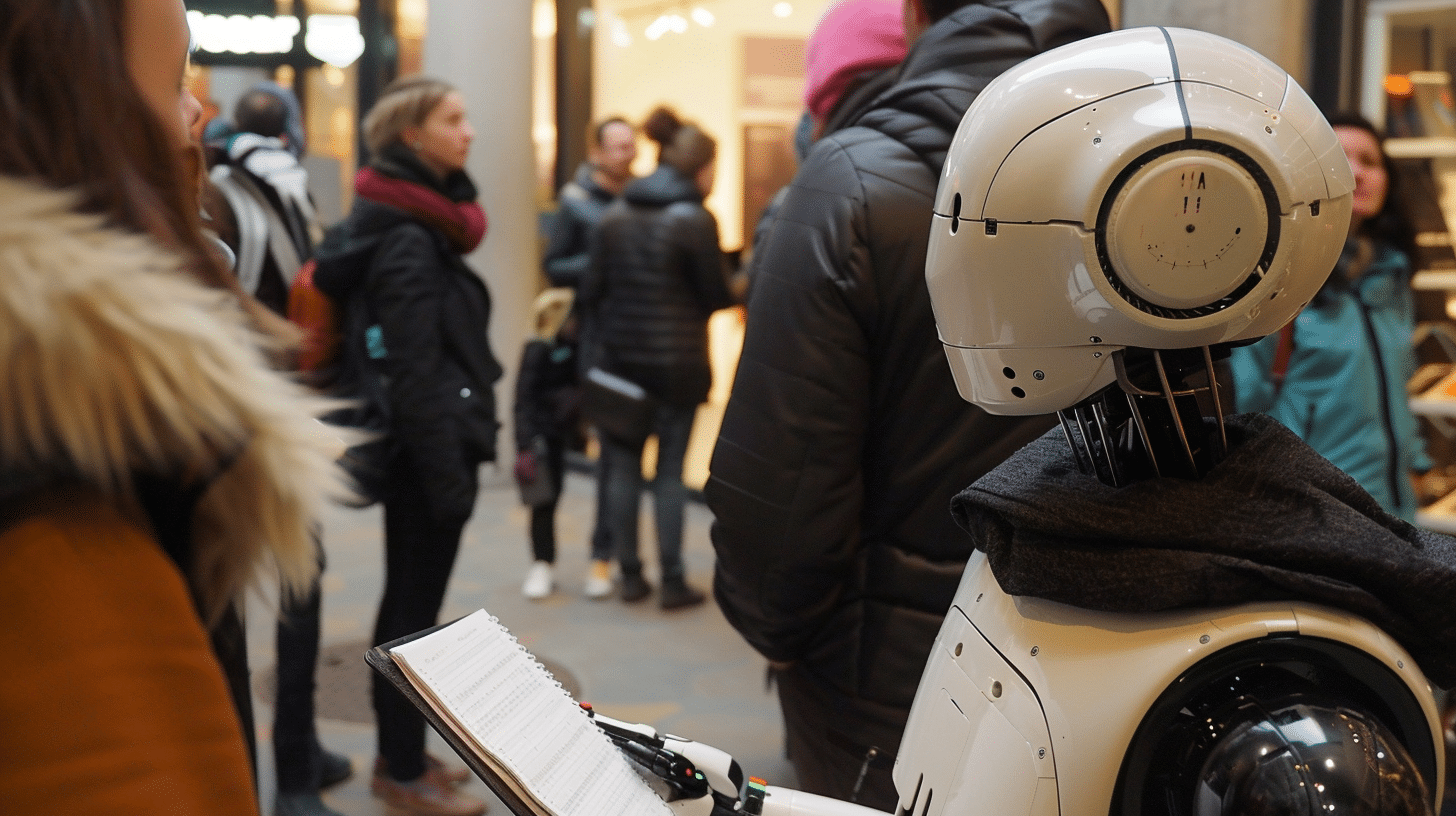

V-JEPA actualmente limitado al análisis visual de videos, pero los investigadores de Meta están trabajando para que también tenga en cuenta el contenido de audio. Según ellos, la V-JEPA representa un paso importante hacia la inteligencia artificial incorporada gracias a su capacidad para comprender intuitivamente la escena, sin necesidad de instrucciones detalladas. Este enfoque de la IA tiene como objetivo crear agentes con capacidades de percepción que les permitan para interactuar con el mundo real.

Por lo tanto, podemos esperar la creación de asistentes virtuales o robots mucho más inteligentes y autónomos impulsados por IA. Serán capaces de comprender su entorno y reaccionar ante ello como lo haría un ser humano.

Nuestro blog está impulsado por lectores. Cuando compra a través de enlaces en nuestro sitio, podemos ganar una comisión de afiliado.